Contrôler son téléphone ou sa tablette uniquement avec le regard ne relèvera bientôt plus du miracle. C'est l'une des nouvelles fonctionnalités prévues par Apple afin de faciliter l'utilisation des personnes en situation de handicap. « Elles auront un impact significatif sur la vie de nombreuses personnes, en leur offrant de nouveaux moyens de communiquer, de contrôler leurs appareils et d'interagir avec le monde qui les entoure », assure sa directrice des politiques et initiatives d'accessibilité mondiales, Sarah Herrlinger. Panorama de ces outils innovants avant leur mise en place « fin 2025 » !

Le suivi des mouvements des yeux

Une simple impulsion du regard suffit désormais à naviguer sur l'iPhone ou l'iPad. Grâce à l'intelligence artificielle, Apple intègre le suivi des mouvements oculaires directement dans ses appareils, sans matériel supplémentaire nécessaire. Pensée pour les personnes en situation de handicap physique, cette fonctionnalité utilise la caméra frontale pour calibrer le regard et permet d'explorer les applications, de sélectionner des éléments via « contrôle d'attente », et même d'activer des gestes comme le balayage ou les clics virtuels. Toutes les données restent traitées localement sur l'appareil, garantissant sécurité et confidentialité. Une avancée qui transforme le regard en véritable outil d'interaction.

Vibrer au rythme de la musique

Avec Music Haptics, les personnes sourdes et malentendantes pourront ressentir la musique avec leurs doigts. Lorsqu'il est activé, le vibreur « taptic engine » de l'iPhone envoie des pressions et des vibrations en rythme. « Il fonctionnera avec des millions de morceaux du catalogue Apple Music », promet la marque à la pomme.

La prise en compte de modes d'élocution atypiques

Imaginez : un simple mot, une phrase personnalisée, et Siri exécute une série d'actions complexes. C'est la promesse de Vocal Shortcuts, bientôt disponible sur iPhone et iPad. En enregistrant des énoncés sur-mesure, l'utilisateur pilote son appareil de manière sur-mesure, sans avoir à s'adapter à une interface figée. Mais Apple va encore plus loin. Avec Listen for Atypical Speech, l'intelligence artificielle apprend à reconnaître des modes d'élocution atypiques, souvent incompris des assistants vocaux traditionnels. Cette technologie embarquée, nourrie à l'apprentissage automatique directement sur l'appareil, s'adresse en particulier aux personnes vivant avec une paralysie cérébrale, une sclérose latérale amyotrophique (SLA) ou ayant subi un AVC.

Un usage facilité au volant !

De son côté, CarPlay – version embarquée d'iOS disponible sur l'écran des voitures – se dote de trois nouvelles fonctionnalités : contrôle vocal, filtres de couleurs et reconnaissance des sons. Grâce à la reconnaissance vocale, il suffit désormais de parler pour piloter CarPlay et lancer une appli, consulter un itinéraire ou changer de musique… sans lever le petit doigt. Un coup de pouce pour les personnes à mobilité réduite, mais pas seulement. Cette fonctionnalité s'adresse aussi aux personnes sourdes ou malentendantes. Avec « reconnaissance des sons », le système capte des bruits ambiants majeurs – klaxon, sirène, alarme – et les transforme en notifications visuelles. Et pour les conducteurs daltoniens ou ayant une vision altérée, Apple ajoute les filtres de couleurs ainsi que des options comme « texte en gras » ou « grande police ». Résultat : une interface plus lisible, plus intuitive, et surtout pensée pour toutes les perceptions visuelles.

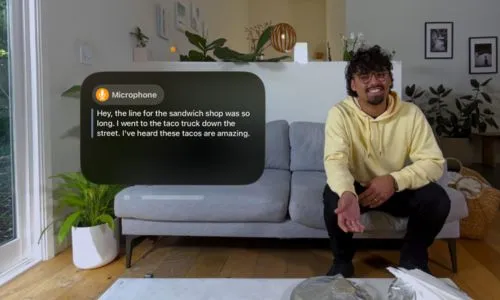

Des sous-titres en direct

Par ailleurs, le système d'exploitation visionOS, dédié au casque de réalité mixte Apple Vision Pro, intègrera les « sous-titres en direct », permettant aux personnes sourdes ou malentendantes de suivre en temps réel des conversations orales ou des contenus audio dans toutes les apps, y compris FaceTime. Grâce à cette avancée, la communication avec une Persona – avatar numérique réaliste – devient accessible à tous. L'expérience immersive est, elle aussi, adaptée : dans les vidéos Apple Immersive Video, les sous-titres peuvent désormais être déplacés à l'écran pour un confort visuel optimal.

L'Apple Vision Pro boostée à l'accessibilité

Côté matériel, le Vision Pro prend en charge de nouveaux appareils auditifs « made for iPhone » et des processeurs auditifs cochléaires. Pour les personnes malvoyantes ou sensibles à la lumière, des options comme « réduire la transparence », « inversion intelligente » et « obscurcir les flashs » viennent compléter l'arsenal d'accessibilité déjà en place. VoiceOver, Zoom, Filtres de couleurs ou encore Accès guidé permettent à chacun de naviguer dans cet environnement en 3D selon ses capacités. Avec un système de contrôle qui s'adapte aux yeux, aux mains ou à la voix, l'Apple Vision Pro propose également des fonctionnalités comme « contrôle de sélection », « actions sonores » ou « contrôle d'attente », pensées pour les personnes en situation de handicap moteur.

Des difficultés enfin prises en compte

En somme, iOS 17 donne un coup d'accélérateur à l'inclusion, en proposant des outils taillés pour celles et ceux que la technologie laissait encore trop souvent de côté. « Étant né sans mains et sans pouvoir marcher, je sais que le monde n'est pas conçu pour répondre à mes besoins, et j'ai été impressionné par la simplicité d'utilisation de visionOS, conclut Ryan Hudson-Peralta, concepteur produit, consultant sur le thème de l'accessibilité. Cela témoigne de l'importance d'une conception pensée pour l'accessibilité et l'inclusivité, et de la puissance de ces fonctionnalités. »

© Apple